はじめに|Apple Intelligenceを2ヶ月使ってみて

2024年に発表され、話題になったApple Intelligence。

Siriの進化やChatGPTとの連携など、AIがいよいよiPhoneやMacにも本格的にやってきた──という印象を受けました。

僕自身もワクワクしながらこの2ヶ月使ってきましたが、正直な感想としては「ちょっと賢くなったけど、大きな違いは感じない」というのが本音です。

でも、それって実はAppleらしい進化なのかも?

この記事では、実際に使って感じたこと・使わなくなった機能・今後への期待まで、Apple Intelligenceのリアルな2ヶ月レビューをお届けします。

Apple IntelligenceとSiriの違いは?

まず「そもそもApple Intelligenceって何?」という話ですが、ざっくり言うと、

Apple製デバイスに組み込まれた生成AI機能の総称

です。

Siriだけでなく、メモや写真、アプリ全体に“賢さ”を加える役割を担っています。

Siriはあくまでフロント(入り口)であり、Apple Intelligenceはその裏で動く頭脳のような存在です。

ただ、見た目や操作感が大きく変わったわけではないので、「Siriが賢くなった」と感じても、それがSiriの進化なのかApple Intelligenceのおかげなのか、判別は正直むずかしい。

実際に便利になったと感じたこと

Siriを使う場面は、以前より確実に増えました。

特に以下のような場面では「おっ、前よりちゃんと理解してくれるな」と感じます。

- タイマーやアラームのセット(あいまいな言い方でも通じる)

- ショートカットの起動(例:「朝の支度を始める」で一括動作)

- メモやリマインダーへの登録

以前は「正確に話さないと失敗する」印象が強かったのが、今は多少アバウトな表現でも意図をくみ取ってくれる場面が増えました。

また、Siriの呼び出しも柔軟になってきています。

音声だけでなく、iPhone/iPadでは画面下を2回タップしてテキスト入力で指示できるようになったのは、静かな場所では本当に便利です。

ChatGPTとの連携は今ひとつ…

期待が大きかった分、ちょっと残念だったのがここ。

- Siri → Apple Intelligence → ChatGPTと、まるで伝言ゲームのように処理が進むため、レスポンスが遅い

- 「◯◯について調べて」と話しかけると、意味を説明してほしいのにSafariで検索されて終わることが多い

→ 「検索する」のか「説明する」のか、“調べる”という言葉の解釈が曖昧なまま処理されるのがもどかしい - ChatGPTによる回答が表示されても、数十秒ほどで画面の表示が自動的に閉じてしまうため、読み終える前に消えてしまうことがある

特に「◯◯について調べて」と頼んだとき、一問一答ではなく、自然な説明がほしかったのにWeb検索で終わってしまうというのは、少し肩透かしでした。

とはいえ、もしこの連携がもっとスムーズに動くようになれば、

アプリを開かずにAIと“会話して”答えがもらえる世界

が現実になるわけで、今後の進化にはかなり期待しています。

Macでは使えない? でも困ってない理由

僕が使っているMacBook Pro(M3 Pro)はApple Intelligenceの対応機種ですが、今のところmacOSではChatGPTへのサインインがエラーになってできません。

設定からChatGPTを追加しようとすると「サインインできませんでした」と表示され、Siri経由でのAI連携も、メモでのAI生成も、何も使えていない状態が2ヶ月続いています。

ただ、だからといって困るかというと…実はあまり困っていません。

というのも、

- Siriを使うのは、ほとんどがiPhoneやApple Watch(たまにiPad)

- Macでは音声よりキーボードの方が早い(仕事柄タイピングに慣れている)

- AIを使うならChatGPTアプリ(Mac版)を直接起動した方が速くて便利

- ChatGPTなら履歴も見返せるし、メモやNotionなど他のアプリとも連携しやすい

また、Siriはキーボードのcommandキーを2回押すことで呼び出せますが、ChatGPTはoptionキー+spaceキーで起動できるため、どちらもホーム画面上でサッと呼び出せるという点では感覚的に似ています。

それでいて、履歴の確認や他アプリとの連携などはChatGPTの方が優秀なので、今のところはMacではChatGPTアプリを中心に使う方が実用的だと感じています。

Apple Intelligenceの生成機能、使ってみてどうだった?

Siri以外にも、Apple Intelligenceにはいくつかの“生成系機能”が搭載されています。 ここでは、実際に試してみた中で感じたことを、用途ごとにまとめてみました。

写真や画像まわりの機能

ビジュアルインテリジェンス

話題になったビジュアルインテリジェンスも、僕自身はあまり活用できていません。

- 最初は友達と一緒に写真を撮って検索したりしていたけど、すぐに使わなくなった

- 仕事柄、外出の機会が少ないため、活躍の場がそもそも少ない

- 「未来っぽい機能」なのに、自分の生活にはまだハマっていないのが少しもったいない

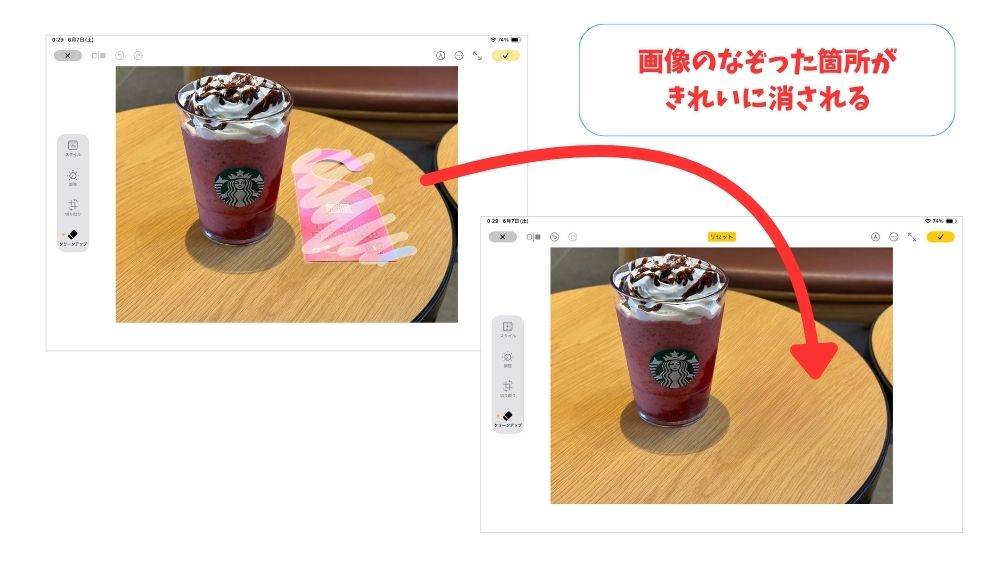

画像クリーンアップ

撮った写真から不要なものを消せる画像クリーンアップはかなり便利です。

- 撮った後に「あ、これ邪魔だったな…」というときに助かる

- 加工跡も自然“っぽく”仕上がることが多く、ぱっと見では気づかれないレベル

ただし、複雑な背景や構造物がある写真では違和感が残ることもあり、AI処理の限界も感じました。

ラフスケッチからの画像生成

ラフスケッチから画像を生成する機能も面白いとは思いましたが、

- 手書きには手書きの良さがある

- 資料として使う場合は、むしろそのままの方が伝わることも

個人的には、逆に「画像からラフスケッチを作る」機能があれば面白いのに…と感じました。

テキストまわりの生成機能

メール要約

受信メールをざっくり把握できるメールの要約機能は便利です。

- 要点だけを素早く把握できるのはありがたい

- ただし、数値の読み取りミスが発生することもある(例:キャッシュバック5円→5万円と表示されてぬか喜び…)

大事な内容ほど、やっぱり原文を読むのが安心です。

作文ツール

文章の下書きを作成してくれる作文ツールも試してみました。

- iPhoneやiPadでは使えたのですが、メール返信で使おうとした際、Gmailを使っているため非対応だったのが残念

- テーマを与えて小説のような文章も生成できるが、設定が少しわかりにくく、ChatGPTの方がやり取りはスムーズ

機能としては面白いけれど、現状では使う場面が限られそうです。

おわりに|“暮らしに寄り添うAI”としてのApple Intelligence

AIというと、これまではちょっと特別で、構えて使うものでした。

でも、Apple Intelligenceは日常の中に“ちょっとだけ”賢さを加えてくれる存在です。

- 音声入力が少しラクになる

- 曖昧な指示でも理解してくれる

- いつものアプリで自然に補助してくれる

こうした“小さな変化”が積み重なることで、気づけばAIが当たり前のように身近にある。

Appleは、そんな“暮らしに溶け込むAI”の形を目指しているのかもしれません。

Siri → Apple Intelligence → ChatGPTの連携がもっとスムーズになれば、科学の最先端だったAIが、まるで友人のようにそばにいる存在になる——そんな未来も、案外すぐそこまで来ているような気がします。

Apple Intelligenceは、その最初のきっかけとして、確かに意味のある一歩だったと感じています。